こんにちは。SEO対策会社のユナイテッドリバーズの岡崎です。

Googleのパンダアップデート導入以降、SEOにおいて最も重要視されているのがコンテンツの品質です。

コンテンツ・イズ・キングなんて言葉が流行りすぎてしまって、逆にいまさら口に出すのは恥ずかしいくらいになりましたね。

パンダを意識したSEOを進める際には、高品質コンテンツの制作と共に、低品質コンテンツを減らしていくことも重要です。とくに長期間運営しているWebサイトの場合は、パンダ以前に制作した量産ページや、内容が古くなってコンテンツの価値が下がってしまったページが存在するケースが少なくありません。

ある程度の規模のWebサイトでは、担当者が全ページの内容を把握するのは困難です。

数百、数千ページを目視でチェックして、低品質なページを洗い出していくのはかなりの苦行といえるでしょう。

そこで今回は、Google Analyticsを利用してそんな低品質コンテンツの洗い出しを効率化する方法を紹介します。

目次

低品質コンテンツとは

本題の前に、低品質コンテンツについて簡単におさらいをします。

要するに「ユーザーの検索意図にマッチしないコンテンツ=低品質」なのですが、これだけではイマイチわかりにくいですよね。

どんなコンテンツが低品質とみなされるのか、箇条書きにしてみます。

低品質コンテンツの特徴

- テキストの量が少なく、情報が乏しい(コンテンツによりますが、最低でも500字以上は欲しいところ)

- ユニークなテキストが少ない(エリア名を変えただけ、Wikipediaからの引用に一言添えただけ…など)

- ユーザーの検索意図に合った役立つ内容が書かれていない

こうしたコンテンツが掲載されているページでは、数値で見ると下記のようなシグナルが表れます。

定量的に表れるシグナル

- 検索流入数が少ない

- 滞在時間が短い(≒コンテンツが読まれていない)

この2つのシグナルのいずれか、もしくは両方が表れているページが低品質である可能性が高いわけです。

こんなものはGoogle Analyticsをチェックすれば一発でわかる…と言いたいところですが、困ったことにGoogle Analyticsでは検索流入数「ゼロ」のページがわかりません。

Webサイトの全ページのリストを用意して、Google Analyticsに表示されない検索流入数「ゼロ」のページを洗い出す必要があります。

Website ExplorerでWebサイトの全ページのURL、titleを取得する

キレイなサイトマップが手元にあればそれと突き合わせてチェックができますが、そうしたデータを持っている方は案外稀だと思います。

かといって手作業で作っていくのはさすがにしんどいですよね。

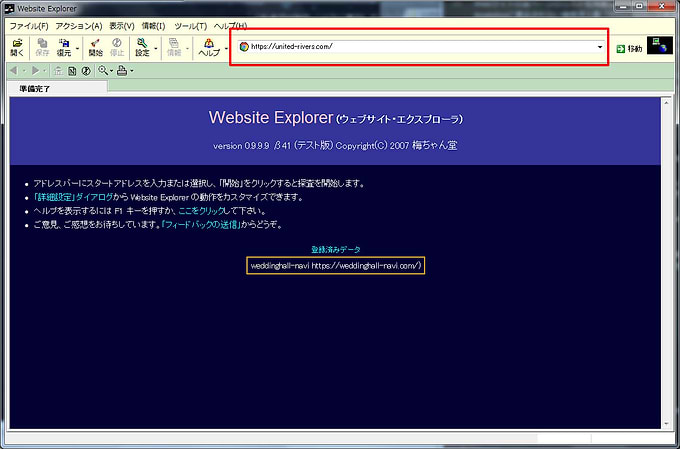

そんなときにおすすめなのが「Website Explorer」というツールです。

Website Explorerは指定したWebサイトをクロールして、URLやtitleの一覧などを取得できるフリーソフトです。リンクのエラーをチェックしたり、XMLサイトマップを作成したりもできます。

使い方ですが、まずWebsite ExplorerのダウンロードページからZIPファイルをダウンロードし、解凍してください。

インストールは不要で、解凍したフォルダ内にある「WEBEX.exe」というファイルをダブルクリックすれば起動できます。

起動したら、アドレスバーに調査したいサイトのURLを入力し、Enterキーか「開始」ボタンをクリックしてください。

こちらのような画面が表示されたら無事に調査が開始されています。サイトの規模、通信環境にもよりますが、時間がかかる処理なので終わるまで他の作業をしていましょう。

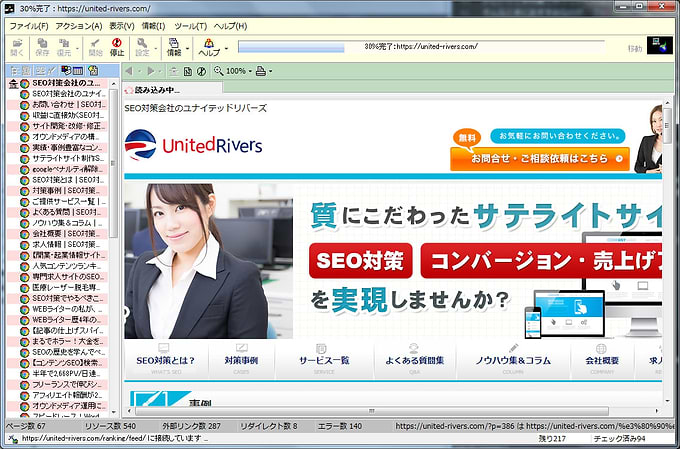

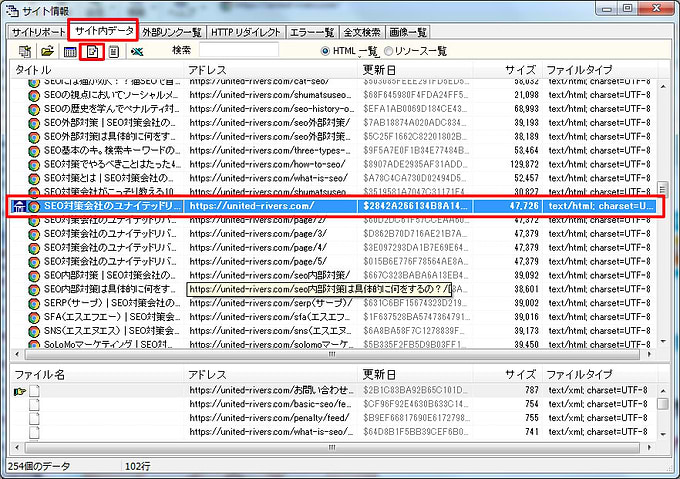

調査が完了すると「サイト情報」という別ウィンドウが開きます。

タブを「サイト内データ」に切り替え、TOPページを選択(家のようなアイコンがついてます)、右クリックかメニューバーから「CSV形式で保存」を選択してください。

保存したCSVファイルを開くとこのようなデータになっています。

いろいろ項目がありますが、今回使うのは「タイトル」とアドレス」のみです。

これが調査したWebサイトの全ページのリストです。

Google Analyticsから各ページの検索流入数、滞在時間を抽出する

次はGoogle Analyticsから各ページの検索流入数と滞在時間を抽出します。

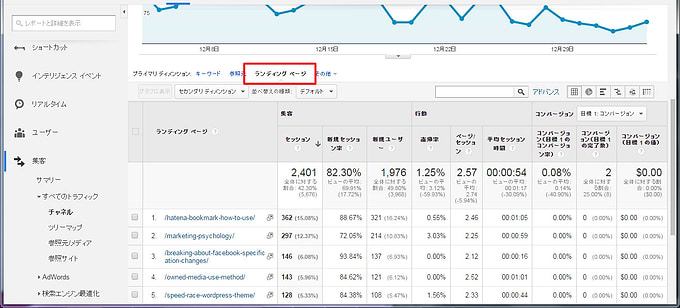

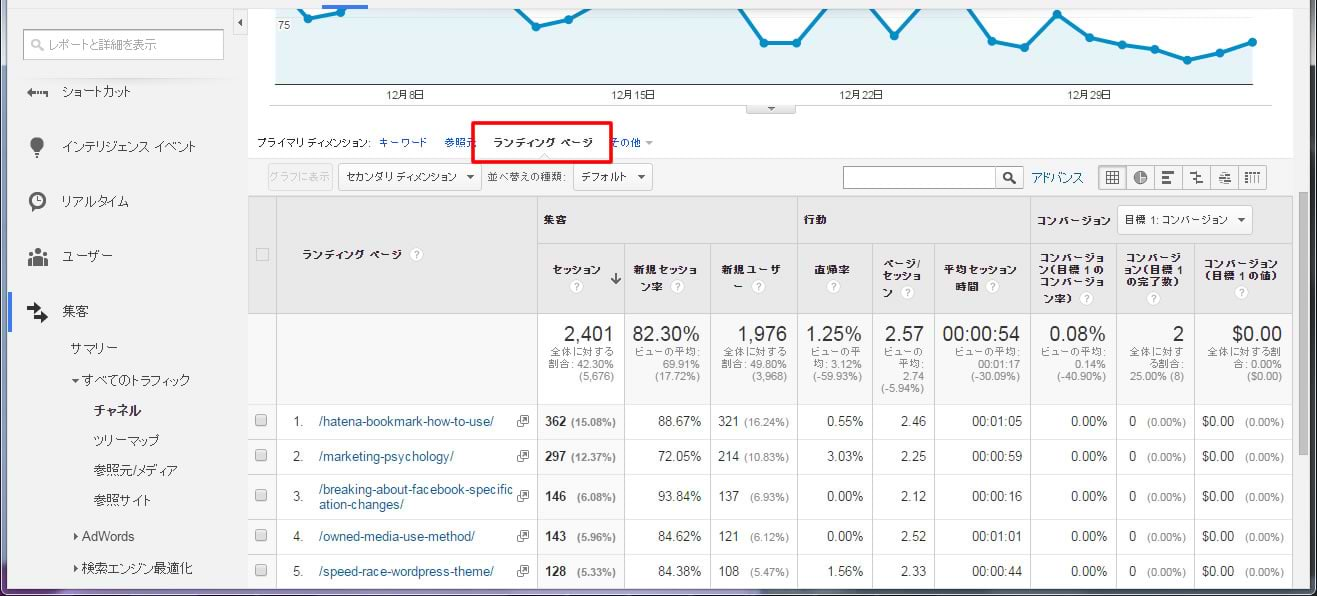

Google Analyticsを開き、左メニュー「チャネル」>「Organic Search」と進みます。

プライマリ ディメンションの「ランディングページ」をクリック。

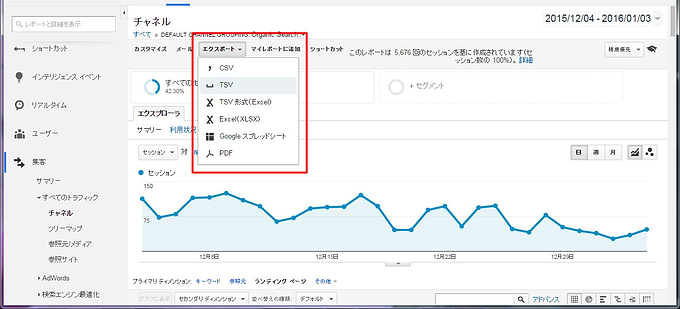

「表示する行数」を選択し、全ページが表示されるように変更。

任意の形式でエクスポートしてください。(個人的には、TSVが文字化けしないのでおすすめです)

これでGoogle Analyticsからのデータ取得は完了です。

Website ExplorerのデータとGoogle Analyticsのデータを突き合わせる

あとは、Website ExplorerのデータにGoogle Analyticsから取得したセッションと滞在時間(平均セッション時間)を加えれば完了です。

URL一致を条件としてVLOOKUP関数を使うと簡単だと思います。

*参考:第三十四回 誰でもわかる&できる!VLOOKUP関数入門ガイド | 本当は怖いExcel(エクセル)の話

こんな形の表ができたら、検索流入数や滞在時間でソートして、数字の悪いページをチェックしていきましょう。

「数字が悪い=100%低品質コンテンツ」というわけではないので、内容を把握しないまま機械的に削除したりしないようにだけ注意してください。

目視の結果、低品質コンテンツと判断できたら、それぞれ対応方針を決めていきます。

低品質コンテンツに対する対応は主として下記の4通りが考えられるでしょう。

状況に応じてマッチする対応をしてください。

- 追記、修正をしてコンテンツの品質を上げる

- 他のページと統合する(※旧ページからの301リダイレクトを忘れずに)

- noindex化(低品質であっても不可欠、修正まで時間がかかるので一時的に…など)

- 削除(手を入れても品質の向上が見込めない、そもそもサイトに不要なページだった…など)

終わりに

低品質コンテンツの対策は多大な工数が必要になることも珍しくありません。

今回紹介した方法を活用するなどして、効率的に進めていきましょう。

また、コンテンツを修正していくときには、対応するキーワードの重要性も考慮して優先順位をつけることをおすすめします。

※トップ画像引用元:flickr.com